Có một số nguồn dữ liệu gần như được mọi công cụ tối ưu hóa (optimizer) máy tìm kiếm sử dụng. Google Search Console (trước đây gọi là các Công cụ Webmaster của Google) có lẽ đã trở nên phổ biến khắp mọi nơi. Có một vài việc bạn có thể làm về GSC, ví dụ từ chối các liên kết, những liên kết không thể hoàn thành được ở bất kỳ đâu, do đó chúng ta phần nào bị buộc phải lệ thuộc vào nó. Tuy nhiên, giống như tất cả các nguồn kiến thức, chúng ta phải tiến hành kiểm tra xác định mức độ tin cậy — liệu chúng ta có thể đánh cược nghề của mình vào các khuyến cáo của công cụ này không? Hãy xem liệu chúng ta có thể hạ bức màn bí ẩn về dữ liệu GSC và xác định, một lần duy nhất, chúng ta có thể tin tưởng vào độ tin cậy của dữ liệu do công cụ này cung cấp không.

Kiểm tra nguồn dữ liệu

Trước khi chúng ta đi vào chi tiết, tôi cho rằng cần thảo luận nhanh về cách chúng ta xử lý vấn đề này. Về cơ bản có hai khái niệm tôi muốn giới thiệu dùng cho phân tích này:tính hiệu lực bên trong và tính hiệu lực bên ngoài.

Tính hiệu lực bên trong (Internal validity)đề cập đến việc dữ liệu có thể hiện chính xác những gì Google biết về site của bạn không.

Tính hiệu lực bên ngoài (External validity)đề cập đến việc dữ liệu có thể hiện chính xác nội dung của web không.

Hai khái niệm này có ý nghĩa hết sức quan trọng với nội dung thảo luận của chúng ta.Tùy thuộc vào vấn đề thảo luận về chủ đề SEO, chúng ta có thể quan tâm hơn đến một hay nhiều vấn đề khác. Ví dụ chúng ta giả định rằng tốc độ trang (page) là một yếu tố thứ hạng cực kỳ quan trọng và chúng ta muốn giúp đỡ một khách hàng. Chúng ta thường có xu hướng quan tâm đến tính hiệu lực bên trong của chỉ số “thời gian cần để tải xuống một trang” của GSC, bởi vì bất kể điều gì xảy ra với một người dùng thực sự, nếu Google cho rằng trang đó có tốc độ tải chậm, chúng ta sẽ mất thứ hạng. Chúng ta phụ thuộc vào chỉ số này vì chúng ta chắc chắn rằng chỉ số đó thể hiện những gì Google biết về sitecủa khách hàng. Mặt khác, nếu chúng ta cố ngăn chặn Google tìm ra các liên kết xấu, chúng ta sẽ quan tâm tới tính hiệu lực bên ngoài của phần “liên kết tới trang của bạn” bởi vì, trong khi Google có thể biết một số liên kết xấu, chúng ta muốn chắc chắn rằng không có liên kết xấu nào khác Google có thể tình cờ tìm được. Do đó, tùy thuộc vào việc các liên kết mẫu của GSC mô tả các liên kết trên web toàn diện tới mức nào, chúng ta có thể bác bỏ chỉ số đó và sử dụng kết hợp các nguồn khác (ví dụ Open Site Explorer, Majestic, và Ahrefs) giúp chúng ta đạt được phạm vi rộng hơn.

Mục đích của việc này đơn giản chỉ để nói rằng chúng ta có thể đánh giá dữ liệu của GSCtheo nhiều góc độ, và chúng ta cần mổ xẻ các góc độ này để biết khi nào có thể tin tưởng vào GSC.

GSC Phần 1: Cải tiến về HTML

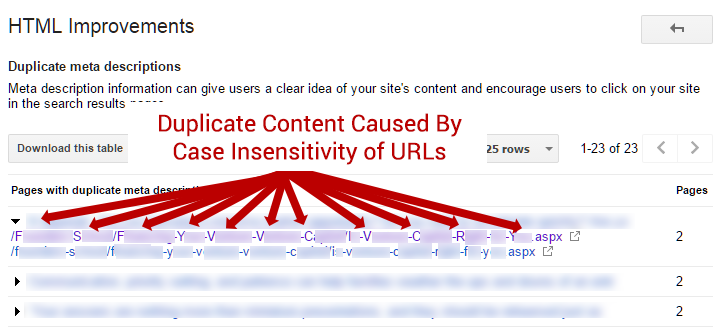

Trong số nhiều tính năng hữu ích trên GSC, Google cung cấp một danh sách các lỗi HTML thường gặp phát hiện được trong quá trình crawl (quá trình thu thập dữ liệu trên website của Googlebot) trên trang của bạn. Phần này, nằm trong mục Search Appearance (Giao diện tìm kiếm)> HTML Improvements (Cải tiến HTML), liệt kê một số lỗi có thể gặp bao gồm Duplicate Titles (Lặp tiêu đề), Duplicate Descriptions (Lặp mô tả), và các khuyến cáo có thể thực hiện khác.Thật may là ví dụ đầu tiên này cho chúng ta cơ hội xây dựng phương pháp để kiểm tra cả tính hiệu lực bên trong và tính hiệu lực bên ngoài của dữ liệu. Như bạn có thể thấy ở hình chụp màn hình bên dưới, GSC đã tìm thấy các siêu mô tả bị lặp (meta descriptions) bởi vì một website có các URL không phân biệt chữ hoa chữ thường và không có tag (thẻ) hợp với quy tắc tiêu chuẩn (canonical) hoặc chuyển hướng để khắc phục lỗi đó. Về cơ bản, bạn có thể đến trang từ /Page.aspx hoặc /page.aspx, và vấn đề này không rõ ràng vì Googlebot đã tìm được URL có và không chứa chữ viết hoa. Chúng ta hãy kiểm tra các khuyến cáo của Google xem có hiệu lực bên ngoài và bên trong hay không.

Tính hiệu lực bên ngoài:

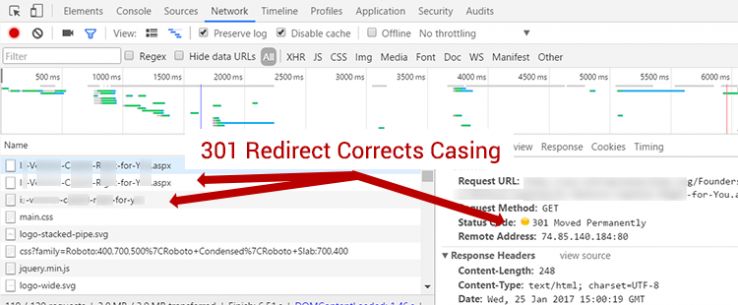

Trong trường hợp này, tính hiệu lực bên ngoài đơn giản đề cập đến việc liệu dữ liệu có phản ánh chính xác các trang đúng như chúng xuất hiện trên Internet không. Như chúng ta có thể hình dung, danh sách cải tiến HTML có thể bị lỗi thời thê thảm tùy thuộc vào tốc độ crawl trên trang của bạn. Trong trường hợp này, trước đó trang đã thực hiện khắc phục vấn đề bằng một chuyển hướng 301 (301 redirect).

Điều này thực ra không có gì ngạc nhiên. Chúng ta không nên kỳ vọng Google sẽ cập nhật phần này của GSC mỗi lần bạn thực hiện một chỉnh sửa đối với website của bạn.Tuy nhiên, điều này cũng cho chúng ta thấy một vấn đề hay gặp với GSC. Có nhiều vấn đề GSC cảnh báo bạn có thể đã được bạn hoặc người phát triển web của bạn khắc phục.Tôi không cho rằng đây là một lỗi với GSC gây ra theo mọi góc độ hình dung, chỉ là một hạn chế chỉ có thể xử lý bằng tần suất crawl có chủ đích nhiều hơn như sử dụng Moz Pro’s Crawl Audit(Kiểm tra Crawl của Moz Pro) hoặc bằng một công cụ độc lập như Screaming Frog.

Tính hiệu lực bên trong:

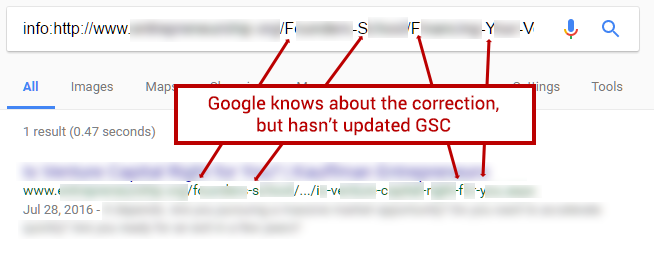

Đây là phần mọi thứ bắt đầu trở nên thú vị. Không có gì ngạc nhiên khi Google không thu thập dữ liệu trang của bạn đủ thường xuyên để lấy cập nhật về trang của bạn theo thời gian thực, chúng ta nên kỳ vọng rằng những gì Google thu thập được (crawled) sẽ được phản ánh chính xác trên GSC. Trường hợp này dường như là không đúng.

Bằng cách thực thi lệnh info:http://concerning-url trên Google sử dụng chữ viết hoa, chúng ta có thể xác định một số thông tin về những gì Google biết về URL. Google trả về kết quả cho phiên bản chữ viết thường của URL! Điều này cho thấy rằng Google cũng biết về chuyển hướng 301 đang khắc phục được vấn đề và đã khắc phục URL trên chỉ mục tìm kiếm. Như bạn có thể hình dung, việc này có thể khiến chúng ta gặp khá nhiều rắc rối. Các khuyến cáo cải tiến HTML trên GSC không chỉ không phản ảnh các thay đổi bạn đã thực hiện với trang của mình, mà còn không phản ánh các chỉnh sửa Google đã biết. Do có sự khác biệt này, tốt nhất nên luôn crawl trang của bạn để phát hiện những vấn đề này ngoài việc sử dụng GSC.

GSC Phần 2: Trạng thái đánh chỉ mục (Index Status)

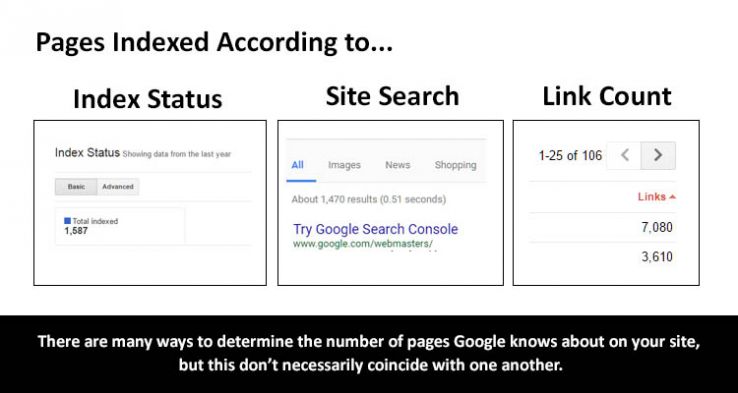

Chỉ số tiếp theo chúng ta cần giải quyết là Trạng thái đánh chỉ mục của Google (Index Status), được cho là sẽ cung cấp cho bạn thông tin chính xác về số lượng trang (page) Google đã đánh chỉ mục cho site của bạn. Phần này có trong mụcGoogle Index (Đánh chỉ mục Google) > Index Status (Trạng thái Đánh chỉ mục). Chúng ta chỉ có thể kiểm tra tính hiệu lực bên trong của chỉ số đặc biệt này vì chỉ số này cung cấp cho chúng ta thông tin về bản thân Google. Có một số cách chúng ta có thể giải quyết vấn đề này…

- Chúng ta có thể so sánh số lượng trang cung cấp trên GSC với site: commands

- Chúng ta có thể so sánh số lượng trang cung cấp trên GSC với số lượng liên kết bên trong với trang chủ (homepage) ở mục các liên kết bên trong (giả định 1 liên kết tới trang chủ từ mọi trang của site)

Chúng ta chọn cả hai.Vấn đề lớn nhất với chỉ số đặc biệt này là việc nó đo lường thông tin gì. Bởi vì GSC cho phép bạn phân quyền phiên bản dạng http, https, www, và không thuộc dạng www của site của bạn một cách độc lập, điều đó có thể gây nhầm lẫn về việc có thông tin gì trong chỉ số Trạng thái Đánh chỉ mục (Index Status).

Chúng ta thấy rằng nếu áp dụng một cách thận trọng nhằm đảm bảo không xảy ra chồng chéo giữa các dạng khác nhau(https với http, www với dạng không phải www), chỉ số Trạng thái Đánh chỉ mục(Index Status metric) dường như liên quan khá nhiều đến lệnh site:site.com trên Google, đặc biệt trên các site nhỏ hơn. Site càng lớn thì chúng ta càng thấy nhiều biến động về con số này, tuy nhiên việc này có thể khắc phục bằng các phép tính xấp xỉ do site:command thực hiện.

Mặc dù chúng ta thấy rằng phương pháp đếm liên kết khó sử dụng hơn. Xem xét đồ họa ở trên Site chúng ta nói đến có 1,587 trang được đánh chỉ mục theo GSC, tuy nhiên trang chủ của site đó có 7,080 liên kết nội bộ. Điều này dường như rất không thực tế, vì chúng ta không có khả năng tìm một trang đơn lẻ, ít hơn nhiều đa phần các trang, với 4 hoặc nhiều hơn liên kết tới trang chủ. Tuy nhiên, giả sử con số này giống với site:command và Trạng thái Đánh chỉ mục của GSC, tôi tin rằng vấn đề ở đây phần nhiều liên quan đến cách thức các liên kết bên trong được thể hiện hơn đến chỉ số Trạng thái Chỉ mục.

Tôi cho rằng sẽ an toàn nếu kết luận rằng chỉ số Index Status có lẽ là chỉ số đáng tin cậy nhất chúng ta có được, xét về số lượng trang thực tế được đưa vào chỉ mục của Google.

GSC Phần 3: Liên kết nội bộ (Internal Links)

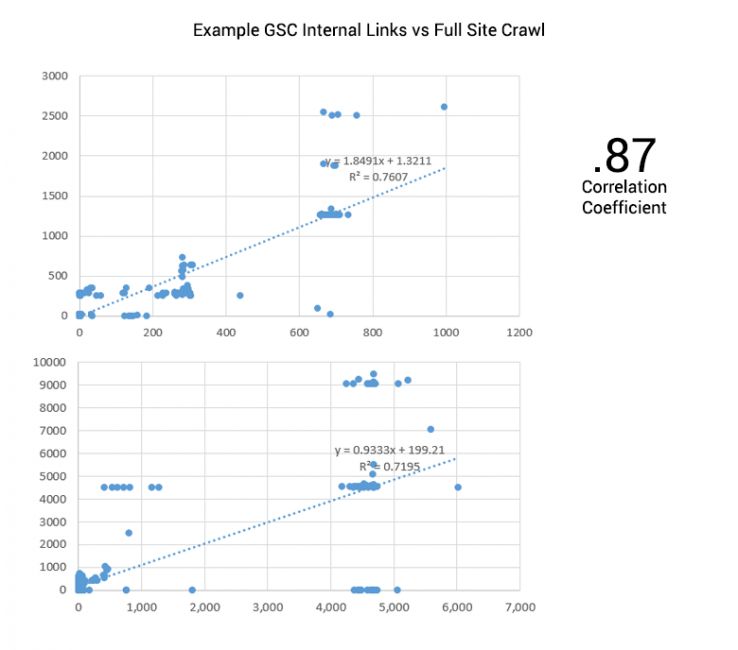

Phần Internal Links có trong mục Search Traffic (Lưu lượng tìm kiếm) > Internal Links (Liên kết nội bộ) dường như ít khi được sử dụng, nhưng có thể mang nhiều ý nghĩa. Nếu External Links cho Google biết những gì người khác nghĩ là quan trọng trên site của bạn, thì Internal Links cho Google biết điều gì bạn cho là quan trọng trên site của bạn. Đây một lần nữa lại là ví dụ hữu ích để chúng ta hiểu được sự khác biệt giữa những gì Google biết về site của bạn và những gì thực sự đúng về site của bạn.

Việc kiểm tra chỉ số này khá đơn giản. Chúng ta lấy số liên kết bên trong do GSC cung cấp và so sánh chúng với các crawl trên toàn bộ site. Khi đó chúng ta có thể xác định xem crawl của Google có đại diện tương đối cho site thực tế không.

Nói chung, hai số liệu này ít liên quan với mức sai lệch tương đối lớn. Dưới một góc độ SEO, tôi thấy điều này rất quan trọng. Google không khởi động tranh chủ của bạn và crawl site của bạn theo đúng cách các crawler site tiêu chuẩn làm (như crawler có trên Moz Pro). Googlebot tiếp cận site của bạn thông qua kết hợp các liên kết bên ngoài, liên kết nội bộ, sitemap, chuyển hướng (redirect), v.v. và cách này có thể cho bạn bức tranh rất khác. Trên thực tế, chúng ta thấy trong một vài trường hợp việc crawl toàn bộ site làm lộ diện hàng trăm liên kết bên trong Googlebot đã bỏ sót. Các trang điều hướng, như trang danh mục (category page) trên blog, có tần suất crawl ít hơn, do đó một số trang không tích lũy đủ số lượng liên kết trên GSC theo đúng kỳ vọng của một người sau khi chỉ xem xét một crawl truyền thống.

Đối với người làm marketing tìm kiếm, trong trường hợp này chúng ta phải quan tâm đến tính hiệu lực bên trong, hoặc những gì Google biết về site của bạn. Tôi thực sự khuyến cáo so sánh con số của Google với crawl site của chính bạn nhằm xác định xem có nội dung quan trọng nào Google xác định đã bị bạn đã bỏ qua trong liên kết bên trong của bạn không.

GSC Phần 4: Liên kết tới site của bạn

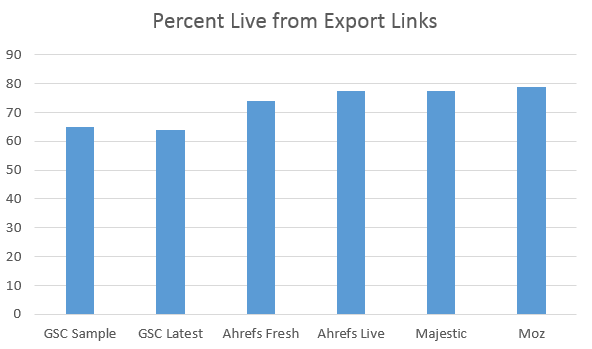

Dữ liệu liên kết luôn là một trong những chỉ số nhiều người mong muốn nhất trong lĩnh vực của chúng ta và quả đúng vậy. Liên kết bên ngoài tiếp tục là yếu tố dự đoán quan trọng nhất đối với thứ hạng và Google đã thừa nhận rất nhiều lần. Vậy thì dữ liệu liên kết của GSC đo lường thông tin gì?

Trong phân tích này, chúng ta so sánh các liên kết do GSC cung cấp cho chúng ta với những liên kết do Ahrefs, Majestic, và Moz cung cấp để tìm hiểu xem các liên kết này có còn hoạt động không. Để công bằng với GSC, công cụ chỉ cung cấp các liên kết mẫu, chúng ta chỉ sử dụng các site có tổng cộng dưới 1,000 backlink, giúp tăng xác suất chúng ta có được một bức tranh đầy đủ (hoặc ít nhất cũng gần đầy đủ) từ GSC. Kết quả thật đáng ngạc nhiên. Các danh sách của GSC, cả “liên kết mẫu” và liên kết “mới nhất,” có hiệu quả thấp nhất xét về “liên kết trực tuyến” với mỗi site chúng ta kiểm tra, chưa từng bao giờ đánh bại được Moz, Majestic, hay Ahrefs.

Tôi muốn có sự rõ ràng và chủ động về hiệu quả của Moz trong bài kiểm tra đặc biệt này. Bởi vì Moz có tổng chỉ mục (total index) nhỏ hơn, nên nhiều khả năng chúng ta chỉ duyệt được các liên kết chất lượng hơn và tồn tại lâu hơn. Việc Majestic và Ahrefs của chúng tôi có hiệu cao hơn một vài điểm phần trăm có khả năng là do kích cỡ chỉ mục (index size) mang lại và việc này phản ánh mức khác biệt về hiệu quả không nhiều lắm. Tuy nhiên, chúng ta không thể bỏ qua vài điểm phần trăm tạo sự khác biệt giữa GSC với toàn bộ 3 chỉ mục liên kết. Xét về tính hiệu lực bên ngoài — tức là, dữ liệu này phản ánh đúng những gì đang thực sự xảy ra trên web tới mức nào — các chỉ mục của bên thứ ba có hiệu quả tốt hơn GSC.

Tuy nhiên, còn về tính hiệu lực bên trong thì sao? Liệu GSC có cho chúng ta cái nhìn mới về chỉ mục backlink thực tế của Google? Dường như cả hai đều vẫn thống nhất bởi vì các liên kết hiếm khi báo cáo mà Google đã biết không còn tồn tại trong chỉ mục. Chúng ta chọn ngẫu nhiên hàng trăm URL “không còn tồn tại nữa” theo kết quả kiểm tra của chúng ta nhằm xác định xem Googlebot vẫn có các phiên bản cũ trong bộ nhớ đệm và đúng là như vậy. Trong khi chúng ta không thể chắc chắn rằng nó thể hiện một bộ chỉ mục liên kết hoàn chỉnh của Google liên quan đến site của bạn, chúng ta có thể tự tin rằng Google có xu hướng chỉ hiển thị kết quả phù hợp với dữ liệu mới nhất của các liên kết.

GSC Phần 5: Phân tích tìm kiếm (Search Analytics)

Search Analytics có lẽ là tính năng quan trọng nhất và được sử dụng nhiều nhất trên Google Search Console, vì tính năng này giúp chúng ta hiểu rõ về dữ liệu bị mất với các cập nhật “không được cung cấp” của Google cho Google Analytics. Nhiều người đã đúng khi nghi ngờ độ chính xác của dữ liệu nên chúng tôi quyết định xem xét kỹ hơn

Phân tích thí nghiệm (Experimental analysis)

Phần Search Analytics giúp chúng ta có cơ hội hiếm hoi được sử dụng một thiết kế thí nghiệm để xác định độ tin cậy của dữ liệu. Khác với các chỉ số khác chúng ta đã kiểm tra, chúng ta có thể kiểm soát thực tế (reality) bằng cách thực hiện nhấp liên kết trong những tình huống cụ thể tới các trang riêng lẻ trên một site. Chúng tôi đã phát triển một nghiên cứu về các hoạt động sau:

- Xây dựng một chuỗi các trang văn bản bản vô nghĩa.

- Liên kết tới các trang này từ nguồn bên trong nhằm khuyến khích đánh chỉ mục.

- Cho tình nguyện viên thực hiện tìm kiếm các cụm từ vô nghĩa, để từ đó chắc chắn trả về nội dung vô nghĩa đúng như những gì chúng tôi đã xây dựng.

- Thay đổi tình huống tìm kiếm của các tình nguyện viên nhằm xác định xem GSC có theo dõi số lần nhấp và số lần xuất hiện quảng cáo (impression) trong những môi trường cụ thể.

- Cho tình nguyện viên nhấp lên các kết quả này.

- Ghi lại các hành động của họ.

- Đối chiếu với dữ liệu do GSC cung cấp.

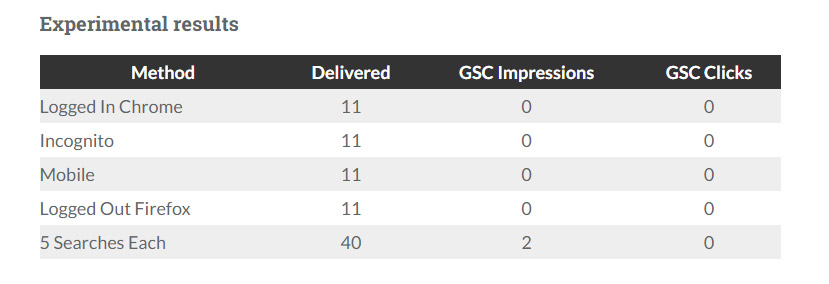

Chúng tôi đã quyết định kiểm tra 5 môi trường khác nhau để biết độ tin cậy của dữ liệu:

- Người dùng thực hiện tìm kiếm đăng nhập vào Google bằng trình duyệt Chrome

- Người dùng thực hiện tìm kiếm đăng xuất, không để lại danh tính trên trình duyệt Chrome

- Người dùng thực hiện tìm kiếm từ thiết bị di động

- Người dùng thực hiện tìm kiếm đăng xuất khỏi trình duyệt Firefox

- Người dùng thực hiện lại 5 lần tìm kiếm giống nhau trong thời gian một ngày

Chúng tôi hy vọng các biến thể này giúp giải đáp những thắc mắc về phương pháp Google áp dụng để thu thập dữ liệu cho GSC. Chúng tôi đã thất vọng thê thảm.

Kết quả thí nghiệm

GSC chỉ ghi lại 2 lần xuất hiện (impression) trong số 84 lần, và có 0 lần nhấp. Với kết quả này, tôi lập tức quan tâm đến khâu thiết kế thí nghiệm. Có lẽ Google không ghi dữ liệu cho các trang này?Có lẽ chúng tôi đã không thực hiện đủ số lượng tối thiểu cần để ghi dữ liệu, chỉ làm lu mờ dữ liệu trong nghiên cứu trước đây trong đó mỗi người thực hiện 5 tìm kiếm?

Thật không may, tất cả các cách giải thích này đều không hợp lý lắm. Trên thực tế, một số trang tổng hợp số lần xuất hiện quảng cáo lên tới hàng trăm đối với các từ khóa kỳ lạ và có thứ hạng thấp vừa xảy ra ngẫu nhiên trong các lần kiểm tra văn bản vô nghĩa. Hơn nữa, có nhiều trang trên site ghi lại số lần xuất hiện và nhấp liên kết rất ít và khi đối chiếu với dữ liệu của Google Analytics, thực ra có rất ít số lần nhấp liên kết. Kết quả khá rõ ràng là chúng ta không thể trông cậy vào GSC, bất kể tình huống người dùng như thế nào, đối với các cụm từ được tìm kiếm nhanh chóng. Với căn cứ này, thì dữ liệu không có hiệu lực bên ngoài — tức là số lần xuất hiện và nhấp liên kết trên GSC không phản ánh đúng số lần xuất hiện và nhấp liên kết trên Google.

Như bạn có thể hình dung, tôi không hài lòng với kết quả này. Có lẽ thiết kế thí nghiệm đã có những giới hạn không lường trước được và phải cần đến phân tích so sánh tiêu chuẩn mới có thể phát hiện ra được.

Phân tích so sánh (Comparative analysis)

Tôi hiểu bước tiếp theo là so sánh dữ liệu GSC với các nguồn khác để xem liệu chúng tôi có thể tìm thấy mối liên hệ giữa dữ liệu được trình bày và các kết quả đo lường thứ cấp có thể giúp hé lộ nguyên nhân tại sao thí nghiệm GSC ban đầu đã phản ánh không đúng chất lượng dữ liệu. Phép so sánh đơn giản nhất là so sánh giữa GSC và Google Analytics. Về lý thuyết, kết quả báo cáo số lần nhấp của GSC phải phản ánh số liệu ghi được về số lần nhấp hữu cơ của Google Analytics từ Google, nếu không giống nhau, thì ít nhất cũng phải tỷ lệ tương ứng với nhau. Do có những quan ngại về quy mô của dự án thí nghiệm này, nên tôi đã quyết định trước hết thử một nhóm các site lớn hơn.

Thật không may, kết quả khác nhau nhiều quá. Site ví dụ đầu tiên nhận được khoảng 6,000 lần nhấp mỗi ngày từ Google Organic Search (Tìm kiếm hữu cơ trên Google) theo GA. Hàng chục trang với hàng trăm lần nhấp hữu cơ mỗi tháng, theo GA, nhận được 0 lần nhấp theo GSC. Tuy nhiên, trong trường hợp này tôi có thể phát hiện một thủ phạm và thủ phạm này có liên quan đến cách theo dõi các lần nhấp.

GSC theo dõi một lần nhấp dựa trên URL trong các kết quả tìm kiếm (ví dụ bạn nhấp lên /pageA.html). Tuy nhiên, chúng ta hãy giả định rằng /pageA.html chuyển hướng tới /pagea.html bởi vì bạn đủ thông minh và quyết định khắc phục vấn đề trong trường hợp này như đã thảo luận ở đầu trang. Nếu Googlebot không cập nhật lần khắc phục đó thì Google Search sẽ vẫn chỉ có URL cũ, tuy nhiên lần nhấp đó vẫn được ghi lại trên Google Analytics trên URL đã chỉnh sửa, bởi vì đây là trang tại đó mã của GA hoạt động. Nhiều khả năng đã xảy ra quá trình dọn dẹp gần đây trên site đầu tiên tôi kiểm tra theo đó GA và GSC có hệ số quan hệ chỉ bằng .52!

Dó đó, tôi tiến hành tìm các đặc tính khác có thể giúp có được bức tranh rõ ràng hơn. Sau khi phân tích một vài đặc tính không có các vấn đề tương tự như trang đầu tiên, chúng tôi xác định được một khoảng quan hệ xấp xỉ từ .94 đến .99 giữa báo cáo của GSC và Google Analytics về các trang đích hữu cơ (organic landing page). Quan hệ này dường như khá mạnh.

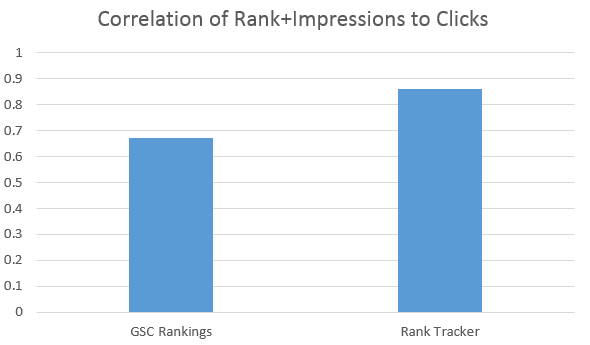

Cuối cùng, chúng tôi thực hiện thêm một dạng phân tích so sánh nữa nhằm xác định độ tin cậy của dữ liệu thứ hạng của GSC. Nhìn chung, số lần nhấp một site nhận được phải là hàm của số lần xuất hiện site đó nhận được và vị trí trên SERP. Trong khi đây rõ ràng là cách nhìn nhận không đầy đủ về tất cả các yếu tố, dường như sẽ công bằng khi nói rằng chúng tôi có thể so sánh chất lượng của hai tập thứ hạng nếu chúng tôi biết số lần xuất hiện và số lần nhấp. Về lý thuyết, phương pháp theo dõi thứ hạng dự đoán số lần nhấp tốt hơn, với số lần xuất hiện biết trước, là phương pháp hiệu quả hơn trong hai phương pháp.

Tôi không bất ngờ, tuy nhiên mối quan hệ này không chặt chẽ lắm.Các phương pháp theo dõi thứ hạng tiêu chuẩn được áp dụng hiệu quả hơn khi dự đoán số lần nhấp thực tế so với thứ hạng thể hiện trên Google Search Console. Chúng ta biết rằng dữ liệu thứ hạng của GSC là một vị trí (thứ hạng) trung bình gần như phản ánh sai bức tranh. Có nhiều kịch bản đúng với điều này tuy nhiên hãy để tôi giải trìnhvề một kịch bản. Thử hình dung bạn thêm nội dung mới và từ khóa của bạn bắt đầu tại vị trí 80, sau đó chuyển lên 70, rồi 60, và cuối cùng là số 1. Bây giờ thử hình dung bạn tạo một đoạn nội dung khác và đoạn nội dung này nằm ở vị trí 40, không bao giờ thay đổi. GSC báo cáo rằng cả hai đều có vị trí trung bình là 40. Mặc dù nội dung ban đầu sẽ nhận được lưu lượng khá lớn trong thời gian ở vị trí số 1, và nội dung thứ hai sẽ không nhận được chút lưu lượng nào.Phương pháp tính trung bình của GSC dựa trên dữ liệu về số lần xuất hiện làm lu mờ các đặc tính nổi bật khiến không thể đưa ra các dự đoán liên quan. Trừ khi phương pháp thu thập dữ liệu thứ hạng của Google cho GSC có sự thay đổi rõ ràng, sẽ không có đủ cơ sở để biết được sự thật về vị trí hiện tại của site bạn.

Thỏa hiệp

Như vậy làm thế nào chúng tôi có thể thỏa hiệp giữa kết quả thí nghiệm với kết quả so sánh, cả mặt tích cực và tiêu cực của GSC Search Analytics? Thực ra, tôi cho rằng có một vài ý chính cần ghi nhớ rõ ràng như sau:

- Dữ liệu về số lần xuất hiện gây nhầm lẫn về mặt tích cực và đơn giản không đúng về mặt tiêu cực: Chúng ta có thể chắc chắn rằng toàn bộ số lần xuất hiện không được thu thập và không được phản ánh chính xác trên dữ liệu GSC.

- Dữ liệu về số lần nhấp có độ chính xác tỷ lệ: Số lần nhấp có thể tin cậy dưới dạng chỉ số tỷ lệ (tức là tương quan với thực tế) nhưng không phải dưới dạng điểm dữ liệu cụ thể (data point).

- Dữ liệu về số lần nhấp hữu ích vì nó cho bạn biết thứ hạng của các URL, chứ không phải vị trí thực tế của các trang.

Việc hiểu rõ cách thỏa hiệp này sẽ có giá trị khá quan trọng. Ví dụ, nếu bạn thấy dữ liệu về số lần nhấp của bạn trên GSC không tỷ lệ với dữ liệu của Google Analytics, nhiều khả năng site của bạn đang sử dụng các chuyển hướng (redirect) theo cách Googlebot chưa phát hiện được hay áp dụng. Việc này cho thấy có một vấn đề quan trọng cần được giải quyết.

Suy ngẫm sau cùng

Google Search Console cung cấp rất nhiều dữ liệu có giá trị cho các quản trị wed (webmaster) thông minh có thể sử dụng để thực hiện các quyết định marketing theo hướng dữ liệu (data-driven). Tuy nhiên, chúng ta vẫn cần phải hoài nghi về dữ liệu này, giống như bất kỳ nguồn dữ liệu nào, và tiếp tục kiểm tra cả tính hiệu lực bên trong và bên ngoài của dữ liệu. Chúng ta cũng cần đặc biệt chú ý đến các phương pháp sử dụng dữ liệu thích hợp để tránh đưa ra những kết luận không an toàn hoặc không tin cậy trong trường hợp thiếu dữ liệu. Có lẽ quan trọng hơn cả là phải: xác minh, xác minh và xác minh. Nếu bạn có khả năng tài chính, hãy sử dụng các công cụ và dịch vụ khác nhau để xác minh dữ liệu bạn tìm được trên Google Search Console, đảm bảo bạn và đội của bạn làm việc với dữ liệu tin cậy. Đồng thời, cũng có rất nhiều người cần cảm ơn ở đây –Michael Cottam, Everett Sizemore, Marshall Simmonds, David Sottimano, Britney Muller, Rand Fishkin, Tiến sĩ Pete và nhiều người khác. Nếu tôi lãng quên bạn, hãy cho tôi biết!

Nguồn www.link-assistant.com

Dịch bởi PersoTrans

Biên tập bởi vietmoz.net

Một bình luận

Bài viết rất hay. Cám ơn nhé